אודות מדור הפקולטה

מדור "הפקולטה" הוא שיתוף פעולה מערכתי ייחודי בין גלובס והפקולטה לניהול באוניברסיטת תל אביב שנועד להנגיש, בשפה בהירה ותמציתית, ידע מחקרי ואקדמי בנושאי כלכלה, אסטרטגיה, שיווק, ביג דאטה, פינטק וחדשנות. הפקולטה לניהול ע"ש קולר של אוניברסיטת ת"א היא מבתי הספר המובילים בעולם למנהל עסקים, וחוקריה עוסקים בסוגיות העדכניות ביותר בענף. במדור יכתבו מיטב חוקרי הפקולטה לניהול לצד בחירת הנושאים, העריכה והתמצות של מערכת גלובס. להרחבת היריעה וצלילה עמוקה יותר למחקרים עצמם, המקורות מצורפים בסוף הכתבה

אודות הכותבים

יהב היא ראשת תוכנית MSc ותאני הוא פרופסור אמריטוס, הפקולטה לניהול באוניברסיטת תל אביב.

במאמר שפרסם ניו יורק טיימס ב-2017 מוצג מקרה שבו אסיר בשם גלן רודריגז המשיך לרצות את עונשו בגלל שתוכנת AI החליטה שטרם הגיע זמן השחרור שלו, זאת אף שעבר שיקום מלא. על מה התבססה ההחלטה? אין לדעת, כיוון שהמערכת פותחה ללא יכולת להסביר את תוצריה והיא מתפקדת כקופסה שחורה, ללא בקרה אנושית.

● הפקולטה | אלה העקרונות שיעזרו לכם להיות חסינים במשבר קיצוני

● הפקולטה | 20 שנה שבשוק הטכנולוגיה העולמי שולטות חמש ענקיות. זו הסיבה העיקרית לכך

● הפקולטה | אם הממשלה לא תקבע יעדים מוגדרים למלחמה, ישראל עלולה ללכת לאיבוד בעזה

מקומות שונים בעולם מציעים לחולים התייעצות עם רובוט רפואי. אבל האם ניתן לסמוך עליו במתן הטיפול המתאים? לא בהכרח, לפחות כל עוד מאחורי ההמלצה שלו אין בקרה אנושית.

ובכל זאת, רבים נוטים להסתמך על המכונה גם בסוגיות מכריעות כאלה מתוך הנחה שהיא חכמה יותר. אך האם באמת אלה פני הדברים?

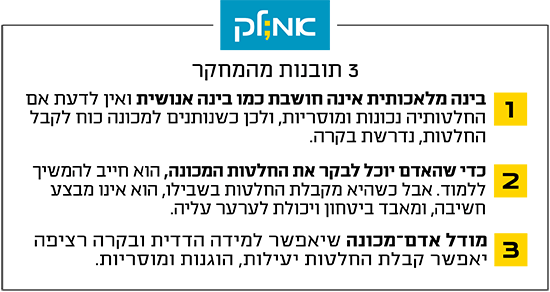

להשאיר את האדם בתהליך

בינה מלאכותית (AIׂ) אינה חושבת כמו בינה אנושית והיא בבסיסה מודל סטטיסטי שלומד מדוגמאות ומידע אנושי. בינה אנושית, מנגד, חותרת ליצירת ידע מופשט המאפשר הכללה לטיפול במקרים חדשים ולא ידועים. מלבד זאת, בינה אנושית ניחנת במודעות עצמית ומוסרית, שלא קיימת (עדיין) בבינה מלאכותית.

לכן, כאשר נותנים למכונה את הכוח לקבל החלטות, נדרשת בקרה אנושית. למשל, במקרה של רודריגז נראה שהתערבות אדם הייתה יכולה למנוע את העוול, או לספק הסבר הולם להשארתו במאסר. כיום קיימת הסכמה רחבה שיש צורך ברגולציה ממשלתית או בינלאומית, שתבקר פעילויות המבוססות על בינה מלאכותית. למעשה, מובילים בתחום כבר התאגדו לדרוש פסק זמן בפיתוח AI כדי לתכנן רגולציה, שתאפשר פיקוח על תעשיית תוכנות ורובוטים. בנוסף לרגולציה, נדרשת בקרה על כל החלטה של מכונה שיש בה סיכון לטעות גורלית, כמו מאסר שווא או דיאגנוזה רפואית שגויה.

בשנים האחרונות הוצע פתרון המאפשר להשאיר את האדם בתהליך. הרעיון הוא לנצל את המומחה האנושי לא רק כדי לאמן את המכונה, אלא גם כדי ליצור שיתוף פעולה בינו לבין המכונה, שכולל בקרה מתמשכת שלו על קבלת ההחלטות שלה. ככל שהבינה המלאכותית תתפשט לעוד תחומים בחיינו, כך נמצא את עצמנו מקבלים עוד ועוד החלטות בשיתוף המכונה, וכך יתרחב הצורך בבקרה.

אך יש פה מעגל קסמים. ככל שהמכונה מקבלת יותר החלטות, לומדת וצוברת ידע, כך עולה החשיבות של בקרה אנושית. מנגד, כדי שיוכל לבקר את החלטות המכונה, במיוחד לנוכח המציאות המשתנה, האדם חייב להמשיך ללמוד ולהתפתח. אלא שכשהמכונה מקבלת החלטות בשבילו, היכולת שלו לקבל בעצמו החלטות איכותיות דועכת, מפני שהוא אינו מבצע את תהליכי החשיבה. בעקבות הירידה ביכולת הגורם האנושי עלול לאבד ביטחון ביכולתו לבקר או לערער עליה.

פרופ' דב תאני, הפקולטה לניהול באוניברסיטת תל אביב / צילום: יח''צ

למעשה, כל אלה יובילו להסתמכות יתר על המכונה ולירידה מתמשכת בלמידה אנושית. כדי לצאת מהמלכוד נדרשת חשיבה מחדש על מערכות אדם-מכונה לקבלת החלטות קריטיות.

מכונה לבדה לא מזהה טרור ברשת

במחקר שערכנו בארבע השנים האחרונות ופורסם באוקטובר 2023 פיתחנו מסגרת עיצובית למערכות אדם-מכונה המאפשרת למידה ובקרה רציפה. אנו מכנים אותה "מערכת אדם-מכונה ללמידה הדדית" (RHML - Reciprocal Human Machine Learning). במסגרת זו למידת המכונה מתבצעת במקביל לזו של האדם, תוך שילוב דינמי של בינה אנושית ובינה מלאכותית. היא מתבצעת בתהליך איטרטיבי (המורכב מסדרה רציפה של ביצועים חוזרים ונשנים של אותה פעולה): בכל סבב האדם מייצר בסיס ידע עבור המכונה, והמכונה מיישמת את הידע על דוגמאות הלמידה ומייצרת משוב לאדם; המשוב מעובד לידע חדש ומועבר כקלט למכונה וחוזר חלילה.

זיהוי סימנים מקדימים לאירוע טרור ברשת הוא דוגמה טובה למערכת אדם-מכונה שלומדת עם הזמן. התבטאויות ברשת שנוגעות לטרור משתנות באופן תכוף, ונדרשת הבנה עמוקה בעולם התוכן הרלוונטי, למשל על הג'יהאד המיליטנטי, כדי להציף את אלה מהן המסיתות לטרור. מומחה אנושי יכול לזהות מאפיינים כאלה כשהוא נתקל בהם ברשת החברתית, אך הוא לא בהכרח ידע להגדיר אותם מראש. לכן האדם צריך את המכונה כדי שתסנן עבורו את המידע הרלוונטי מהרשת. על בסיס הידע המסונן הוא יוכל לזהות וללמוד את צורת ההתבטאות המסיתה לטרור.

פרופ' ענבל יהב / צילום: חן גלילי

מנגד, המכונה צריכה את האדם כדי להרחיב את המודל הסטטיסטי שלה, שעל בסיסו היא מנבאת תוצאות. זה הבסיס ללמידה הדדית ביניהם, והוא חייב להתעדכן ככל שהסביבה משתנה. בדרך זו הראינו במחקר שלאורך זמן ניתן לשפר את הזיהוי המוקדם של סימני טרור ברשת באופן ניכר ובמקביל לשפר את הידע של המומחה.

המודל של RHML מבטיח שהאדם והמכונה יהיו מעורבים בתהליך קבלת ההחלטות כך שיהיו יעילות, הוגנות ומוסריות. המודל משנה את הדרך בה אנו תופסים את העיצוב של מערכות אדם-בינה מלאכותית.

לתשומת לבכם: מערכת גלובס חותרת לשיח מגוון, ענייני ומכבד בהתאם ל

קוד האתי

המופיע

בדו"ח האמון

לפיו אנו פועלים. ביטויי אלימות, גזענות, הסתה או כל שיח בלתי הולם אחר מסוננים בצורה

אוטומטית ולא יפורסמו באתר.